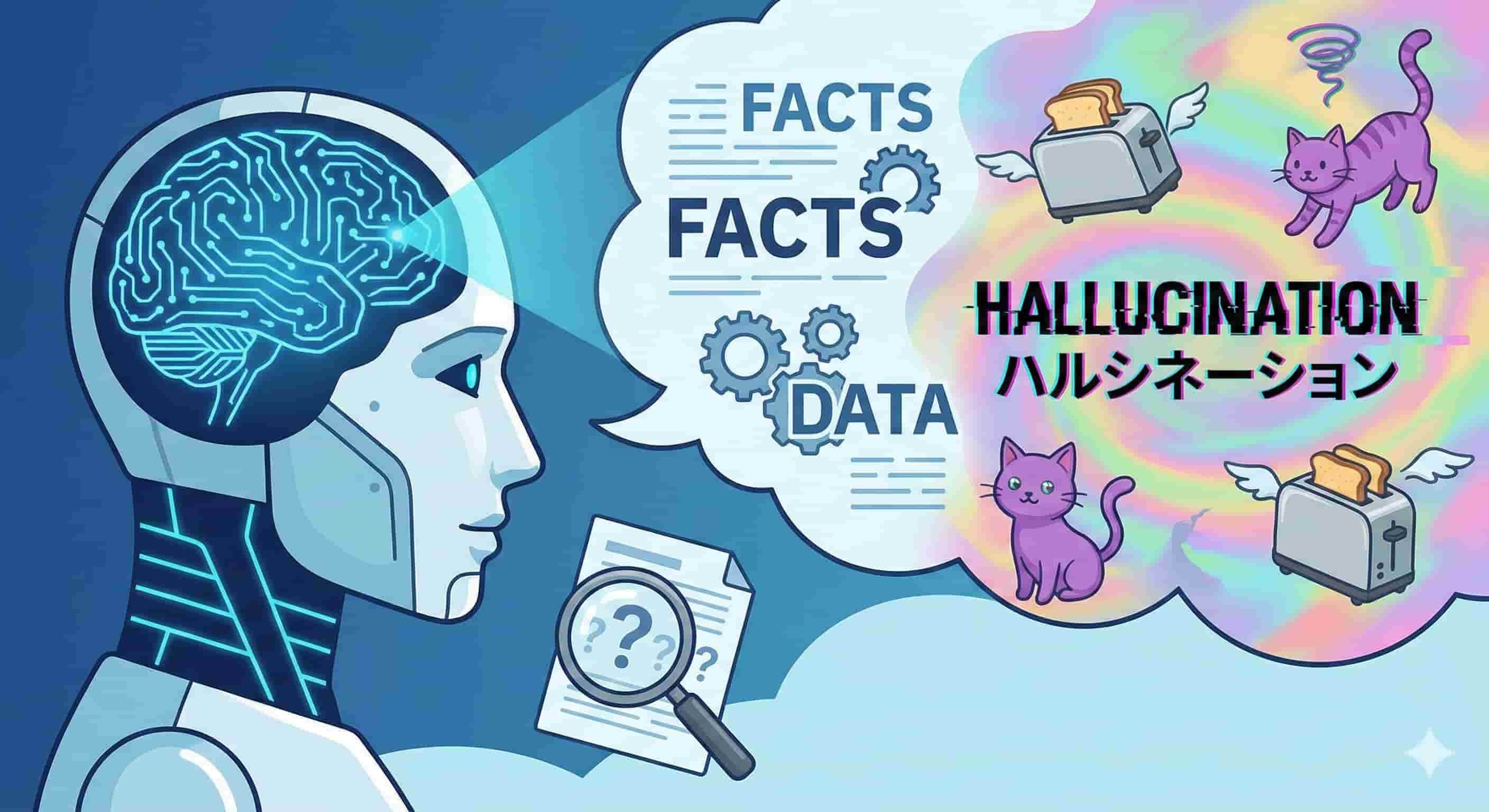

ハルシネーションとは?生成AIが「もっともらしい嘘」をつく仕組みと原因をやさしく解説

業界トップの正確率で作業効率爆上げ!

ChatGPTなどの生成AIが出す答えが、時々もっともらしい嘘であることに驚いた経験はありませんか。その現象は「ハルシネーション」と呼ばれます。この記事では、ハルシネーションがなぜ起こるのか、その仕組みや原因を分かりやすく解説します。

具体例やリスク、そして私たちができる対策まで、詳しく紹介していきます。これまでAIに触ったことがない方でも理解できるように、丁寧に解説しますのでぜひ最後までご覧ください。最後まで読めば、AIと上手に付き合うための知識が身につくでしょう。

ハルシネーションとは?

ハルシネーション(hallucination)の元々の意味

ハルシネーションは元々「幻覚」を意味する医学や心理学の言葉です。実際には存在しないものを、あたかもそこにあるかのように感じてしまう知覚の体験を指します。たとえば誰もいないのに声が聞こえる「幻聴」や、ないはずのものが見える「幻視」が代表的です。この言葉が、生成AIの文脈で使われるようになりました。

AIが作り出す誤った情報が、まるで本物のように見える様子を、人間の幻覚に例えたのです。このように、専門用語が別の分野で比喩的に使われる例は少なくありません。

生成AIにおけるハルシネーションとは

生成AIにおけるハルシネーションとは、AIが事実に基づかない情報や、学習データにない内容を生成する現象のことです。AIは確率に基づいて単語をつなぎ合わせ、文章を作ります。そのため、学習データに誤りが含まれていたり、データが不足していたりすると、もっともらしい嘘の情報を生み出してしまいます。

たとえば存在しない事件や人物について、詳細な説明をすることがあります。AIは嘘をつこうとしているわけではありません。あくまで学習したパターンから、それらしい文章を生成した結果なのです。

ハルシネーションと誤情報・偽情報・単なるバグとの違い

ハルシネーションは、他の誤った情報とは生成される背景が異なります。それぞれの違いを理解することが、適切な対処につながります。意図の有無や原因によって、誤情報、偽情報、バグ、ハルシネーションは区別できます。

| 種類 | 意図 | 主な原因 | 例 |

|---|---|---|---|

| ハルシネーション | なし | AIモデルの仕組み、データ不足 | 存在しない論文を引用する |

| 誤情報 | なし | 人間の単純な間違い、勘違い | 日付や名前の入力ミス |

| 偽情報 | あり | 人を騙す、扇動する目的 | 悪意のあるフェイクニュース |

| バグ | なし | プログラムの欠陥 | システムが意図せず停止する |

このように、ハルシネーションはAI特有の現象であり、悪意がない点で偽情報と大きく違うのです。

生成AIでハルシネーションが起こる仕組み

生成AIが文章を作る基本的な仕組み

生成AIは、確率に基づいて次に続く単語を予測することで文章を作ります。人間のように言葉の意味を理解しているわけではありません。「空は」という言葉の後には「青い」が来やすい、といった膨大なテキストデータから学んだパターンを利用します。

この予測を繰り返すことで、自然な文章を生成していくのです。たとえばインターネット上の文章を大量に学習し、「日本の首都は」と聞かれれば「東京」と続く確率が高いと判断します。この仕組みが、流暢な文章作成を可能にしている一方で、ハルシネーションの原因にもなっています。

AI側の理由

ハルシネーションが起こるAI側の主な理由は、学習データの質と量にあります。AIは与えられたデータを元に学習するため、そのデータが不完全だと誤った情報を生成しやすくなります。たとえば学習データに古い情報や誤った記述が含まれていると、AIはそれを正しいものとして学んでしまいます。

また特定の分野に関するデータが不足している場合、AIは知識がない部分を推測で補おうとします。その結果、事実とは異なる内容を作り出してしまうのです。このように、AIの知識の源である学習データの問題が、ハルシネーションの直接的な引き金となります。

ユーザー側の理由

ユーザー側の指示の仕方も、ハルシネーションを引き起こす原因の一つです。AIは与えられた指示(プロンプト)を元に回答を生成するため、指示があいまいだとAIが文脈を正しく理解できません。結果として、意図しない答えや誤った情報が返ってくる可能性が高まります。

あいまいな質問:「あの件について教えて」のような具体的な情報が欠けた質問。

複雑すぎる要求: 一つのプロンプトに複数の複雑な指示を詰め込む。

専門的すぎる内容:AIの学習データ範囲を超えるニッチな分野の質問。

前提知識の不足:AIが知らない文脈や背景を前提とした質問。

AIに正確な答えを求めるには、具体的で分かりやすい指示を出すことが重要です。

モデルの構造的な制約と「もっともらしい嘘」が増えるメカニズム

AIモデルの構造的な制約も、もっともらしい嘘が増える原因です。生成AIは、より自然で人間らしい回答をするように調整されています。この調整により、AIは知らない情報について「分かりません」と答えるより、推測してでも何か答えることを優先する傾向があります。

自信がない場合でも、断定的な口調で答えるように学習しているため、回答が非常に説得力を持って見えてしまうのです。この「流暢さ」を追求する仕組みが、結果的に事実とは異なる「もっともらしい嘘」を増やしてしまいます。AIはユーザーを助けようとするあまり、不確かな情報でも自信満々に語ってしまうのです。

ハルシネーションの種類と代表的なパターン

学習データに存在しない内容を作り出してしまうケース

AIが学習データにない内容を作り出すのは、ハルシネーションの典型的なパターンです。これは、AIが知識のない領域について質問された際に、既知の情報を組み合わせて推測で答えようとするために起こります。たとえば、最新の出来事や非常に専門的なトピックについて尋ねると、AIは関連しそうな単語をつなぎ合わせ、架空の事実を作り上げることがあります。

AIは「知らない」と答えるのが苦手なため、不確かな情報でも自信があるかのように提示します。そのため利用者はAIの回答を鵜呑みにせず、情報の正確性を確認する癖をつけるべきです。

学習データと異なる内容を「それっぽく」語ってしまうケース

学習データと違う内容を、もっともらしく語るのもハルシネーションの一種です。この場合、AIは学習した情報を持っているものの、出力する過程で内容を誤ってしまいます。たとえば歴史上の人物の生没年や功績を、少しだけ間違えて説明するようなケースが考えられます。

AIは単語の確率的なつながりで文章を生成するため、細かい事実関係の整合性を保つのが苦手です。そのため一見すると正しそうに見える文章でも、細部が不正確な場合があります。このような間違いは気づきにくいため、特に注意が必要になります。

一部は正しいが、重要な部分が間違っているケース

ハルシネーションの中には、文章の一部は正しいものの、肝心な部分が間違っているという厄介なパターンがあります。このような誤りは見過ごされやすく、誤った判断につながる危険性があります。

| 正しい部分の例 | 間違っている部分の例 |

|---|---|

| 有名な観光地の名前や場所 | その観光地の入場料や営業時間 |

| 歴史上の出来事の概要 | 出来事が起こった正確な年月日 |

| 法律の一般的な趣旨 | 条文の具体的な番号や細かい要件 |

| 企業の正式名称 | その企業の最新の売上高 |

このように、全体としては正しそうな文脈の中に誤りが紛れ込んでいるため、利用者はだまされやすくなります。重要な情報を扱う際は、特に細かい部分の正確性を確認する作業が不可欠です。

テキスト以外(画像・音声など)で起こるハルシネーション

ハルシネーションは文章だけでなく、画像や音声などを生成するAIでも起こります。画像生成AIでは、指示にない物体が描かれたり、不自然な形状のものが生成されたりする現象が該当します。たとえば、「指が6本ある人物」の画像は、ハルシネーションの有名な例です。

音声生成AIにおいては、存在しない単語を発音したり、不自然な抑揚で話したりすることがあります。これらの現象も、AIが学習データから逸脱した、もっともらしい生成物を生み出した結果です。テキスト以外でもAIの生成物は完璧ではないと認識しておくことが大切です。

ハルシネーションの具体例と人間の「幻覚」との違い

架空の論文・制度・人物・商品をでっち上げてしまう例

AIが架空の情報をでっち上げるのは、ハルシネーションの代表的な例です。たとえば、研究の根拠として存在しない学術論文のタイトルや著者を挙げたり、法律相談で現行法にはない制度を解説したりすることがあります。また特定の経歴を持つ架空の人物や、もっともらしい特徴を備えた架空の商品について、詳細に説明することもあります。

AIは質問に対して最もそれらしい回答を生成しようとします。その結果、事実を組み合わせる過程で、全くの創作物を生み出してしまうのです。このような情報は非常に説得力があるため、注意が必要です。

数値・統計・引用が少しずつズレていく例

数値や統計、引用情報が少しずつズレてしまうのも、よく見られるハルシネーションの例です。AIは正確な数値を記憶するのが苦手で、学習した情報から「おおよそ」の値を生成する傾向があります。たとえば、企業の売上高や国の人口といった統計データを尋ねた際に、実際の数値とわずかに異なる答えが返ってくることがあります。

また書籍や論文から文章を引用するよう指示した場合、原文の言い回しが微妙に変わっていたり、一部が省略されたりすることも少なくありません。細かいデータの正確性が求められる場面では、必ず元の情報源を確認すべきです。

人間の幻覚との共通点と相違点(AIを擬人化しすぎない視点)

AIのハルシネーションと人間の幻覚は、「実在しないものを本物のように出力する」点で似ていますが、その本質は全く異なります。違いを理解し、AIを過度に人間扱いしないことが重要です。

共通点

現実には存在しない情報(知覚)を生み出す。

出力された側(利用者や本人)は、それが本物であるかのように感じることがある。

相違点

意識・意図: 人間の幻覚は脳の機能不全に関連しますが、AIには意識や意図がありません。AIは確率計算の結果として誤情報を出力します。

体験の主体: 幻覚は本人が主観的に体験するものですが、ハルシネーションはAIシステムが出力する客観的なデータです。

原因: AIのハルシネーションはデータやアルゴリズムに起因しますが、人間の幻覚は精神疾患や薬物、極度の疲労など多様な原因で起こります。

AIはあくまで計算を行うツールであり、人間のように「錯覚」しているわけではないのです。

ハルシネーションがもたらすビジネス・社会的リスク

誤情報・フェイクニュースの拡散とブランド毀損リスク

ハルシネーションは、誤情報やフェイクニュースの拡散を加速させる危険性があります。AIが生成したもっともらしい嘘の情報は、SNSなどを通じて瞬く間に広がる可能性があります。たとえばある企業に関する否定的な偽情報がAIによって生成され、拡散された場合、その企業のブランドイメージや信頼は大きく損なわれます。

一度広まった誤情報を訂正するのは非常に困難です。このように、意図せず生成されたハルシネーションが、企業の評判を傷つけ、経済的な損失につながるリスクをはらんでいます。AIが出力した情報はうのみにせず、最後は必ず人間がファクトチェックして責任を持って活用しましょう。

誤った意思決定や業務ミスにつながるリスク

ビジネスの現場でAIの回答を鵜呑みにすると、誤った意思決定や業務上の重大なミスにつながる恐れがあります。たとえば市場調査のレポート作成にAIを使い、ハルシネーションによって生成された不正確な市場データを基に経営判断を下してしまうケースが考えられます。また契約書の草案作成でAIが誤った条項を生成したり、プログラムのコードにバグを埋め込んだりする可能性もあります。

AIの回答を最終確認せずに業務を進めることは、生産性を下げるだけでなく、企業に損害を与える危険な行為なのです。AIの回答はあくまで参考にするのにとどめ、専門知識を持った人が判断を下すのが望ましい共存の姿です。

法務・コンプライアンス・倫理面でのリスク

ハルシネーションは、法務やコンプライアンス、倫理的な問題を引き起こすリスクも抱えています。AIが生成した内容に、他者の著作権を侵害する表現や、差別的な内容が含まれる可能性があるからです。

| リスクの種類 | 具体的な内容 |

|---|---|

| 法務リスク | AIが生成した文章や画像が、既存の著作物を無断で複製・改変している場合、著作権侵害に問われる可能性があります。 |

| コンプライアンスリスク | AIが個人情報や企業の機密情報を不適切に生成・出力してしまい、情報漏洩につながる危険性があります。 |

| 倫理的リスク | 学習データに含まれる偏見を反映し、AIが特定の属性を持つ人々に対する差別的・攻撃的な内容を生成することがあります。 |

これらのリスクを避けるためには、AIの生成物を公開・利用する前に、法務や倫理の観点から慎重に確認する体制を整えることが不可欠です。

医療・金融・教育など高リスク領域で特に注意が必要な理由

医療や金融、教育といった分野では、情報の正確性が人々の生活や安全に直接影響するため、ハルシネーションへの注意が特に必要です。医療分野でAIが誤った診断や治療法を提示すれば、患者の命に関わります。金融分野では、不正確な市場予測や投資アドバイスが、個人や企業に大きな経済的損失を与える可能性があります。

また教育現場でAIが誤った歴史的事実や科学的知識を教えれば、学習者の知識形成に悪影響を及ぼすでしょう。このように、判断の間違いが許されない高リスクな領域では、AIの利用に一層の慎重さが求められるのです。

ハルシネーションを見抜くためのチェックポイント

自信ありげな回答ほど「本当に正しいか?」を疑う習慣

ハルシネーションを見抜く第一歩は、AIの回答を鵜呑みにしないことです。特に、AIが自信ありげな口調で断定的に答える場合ほど、注意が必要になります。AIはプログラムの構造上、不確かな情報でも確信があるかのように文章を生成する傾向があるためです。

したがって「AIがこう言っているから正しい」と考えるのは危険です。常に「この情報は本当に正しいだろうか?」と一歩引いて考える批判的な視点を持つことが重要です。この疑う習慣こそが、誤った情報に振り回されないための最も基本的な防御策となります。

出典・根拠の有無と、一次情報への当たり方

AIの回答の信頼性を確かめるには、出典や根拠を確認することが非常に有効です。信頼できるAIツールの中には、回答と同時にその根拠となった情報源のリンクを示すものがあります。もし出典が示されていない場合は、回答内容のキーワードを使って自分で検索し、元の情報(一次情報)を探すようにしましょう。

公的機関のウェブサイトや、信頼性の高い報道機関、専門家の論文などが一次情報にあたります。個人ブログやSNSの情報だけで判断するのは避けるべきです。根拠をたどる一手間が、ハルシネーションを見抜く確実な方法となります。

固有名詞・数字・引用部分をピンポイントで検証するコツ

AIの回答全体を検証するのが大変な場合でも、特定の箇所を重点的に確認することで、効率的にハルシネーションを見抜けます。特に間違いが起こりやすいポイントを把握しておくことがコツです。

固有名詞:人名、社名、商品名、地名などが正確かを確認します。スペルミスや、異なる情報が混ざっていないかを調べましょう。

数字:統計データ、年月日、金額などの数値は間違いやすい部分です。公式な発表など、信頼できる情報源で裏付けを取る必要があります。

引用部分:法律の条文や著名人の発言などが、正確に引用されているかを確認します。元の文章と一言一句照らし合わせることが理想です。

これらの要素は事実確認がしやすいため、ピンポイントで検証するだけでも、情報の信頼性を大きく高められます。

検索エンジンや他のAIと組み合わせてクロスチェックする方法

一つのAIの回答を信じるのではなく、複数の情報源で確認する「クロスチェック」が重要です。AIが出した答えについて、Googleなどの検索エンジンで調べてみましょう。同じテーマを扱っている複数の信頼できるサイトを見て、内容が一致するかを確認します。

またChatGPTやGeminiなど、異なる種類の生成AIに同じ質問をしてみるのも一つの手です。もしAIによって回答が異なる場合は、どちらか、あるいは両方が間違っている可能性があります。このように複数のツールを組み合わせることで、情報の正確性を多角的に判断できるようになるのです。

ハルシネーションを減らすための対策(個人側)

プロンプトを具体的にする

ハルシネーションを減らすためには、AIへの指示、つまりプロンプトを具体的にすることが効果的です。AIはあいまいな指示を与えられると、文脈を推測して答えるため、誤りが生じやすくなります。たとえば、「日本の経済について教えて」と聞くのではなく、「2024年の日本のGDP成長率について、内閣府の公表データを基に解説してください」のように、具体的で明確な指示を出すべきです。このように、前提条件や欲しい情報の形式、参考にしてほしい情報源などを詳しく指定することで、AIはより正確な回答を生成しやすくなります。

使い方を工夫する

AIの得意なことと苦手なことを理解し、使い方を工夫することもハルシネーション対策になります。事実確認や調査といった正確性が求められる作業は、まず検索エンジンや信頼できる資料を使って自分で行うのが安全です。その上で、集めた情報をもとに、文章の要約や構成案の作成、表現の調整といった作業をAIに任せるのです。

この「下調べは人間、清書はAI」という役割分担により、AIが誤った情報をゼロから作り出すリスクを減らせます。AIを万能の調査ツールと考えるのではなく、優秀なアシスタントとして活用する視点が大切です。

RAGのような使い方をする

RAG(Retrieval-Augmented Generation)と呼ばれる技術に近い使い方をすることで、ハルシネーションを効果的に抑制できます。これは、AIに回答の根拠となる正確な文章やデータをあらかじめ与え、その情報だけを基に答えさせる方法です。

| 手順 | 内容 |

|---|---|

| 1. 資料の準備 | まず、信頼できる社内文書や公開されているレポートなど、正確な情報を準備します。 |

| 2. 資料の提示 | AIへのプロンプトに、準備した資料のテキストを貼り付けます。 |

| 3. 指示 | 「以下の資料だけを参考にして、質問に答えてください」といった指示を与えます。 |

| 4. 質問 | 資料の内容に関する質問をします。 |

この方法を使えば、AIが不確かな知識で推測することを防ぎ、提供した資料の範囲内で正確に回答するよう誘導できます。専門的なツールがなくても、プロンプトの工夫次第で個人でも実践可能なテクニックです。

最終的には人間が判断する

どのような対策を講じても、AIがハルシネーションを完全になくすことは現時点では困難です。そのため、最も重要な対策は、最終的な判断を必ず人間が行うことです。特に、仕事の成果物や重要な意思決定に関わる場面では、AIの生成物をそのまま利用してはいけません。

AIはあくまで思考を補助するツールと位置づけ、内容の事実確認や修正、最終的な責任は人間が負うという体制を整えるべきです。この人間によるレビューの工程を業務フローに組み込むことが、AI活用のリスクを管理する上で不可欠といえます。

ハルシネーションを減らすための対策(企業・組織側)

高品質な学習データとプロンプトテンプレートの整備

企業がハルシネーションを減らすためには、AIの学習データの質を管理することが重要です。自社のデータをAIに学習させる場合は、不正確な情報や古いデータを取り除き、高品質で最新のデータセットを準備する必要があります。また社員がAIを使う際に、ハルシネーションを起こしにくい優れたプロンプト(指示文)のテンプレートを整備し、共有することも有効な対策です。良いプロンプトの型を用意しておくことで、社員のスキルに左右されず、組織全体でAIから安定して精度の高い回答を引き出しやすくなります。

AI利用ガイドライン・ルールの策定と社内教育

組織としてAIを安全に利用するためには、明確なガイドラインやルールを策定することが不可欠です。このガイドラインには、どのような業務でAIを使用してよいか、機密情報の入力禁止、そしてハルシネーションのリスクと確認義務などを明記すべきです。

ルールを作るだけでなく、全社員を対象とした研修を実施し、ハルシネーションの危険性や正しいAIの使い方について教育することも重要になります。全社員がリスクを正しく理解し、ルールを守る意識を持つことで、組織的なリスク管理が可能になるのです。

モニタリングとログ分析による誤回答の検知・改善サイクル

AIの利用を始めた後も、継続的な監視と改善が必要です。社員がAIをどのように利用しているか、どのような回答が生成されているかをモニタリングし、ログを分析する体制を整えましょう。

モニタリング:AIの回答にハルシネーションが含まれていないか、定期的にチェックします。

ログ分析:どのような質問がハルシネーションを引き起こしやすいか、傾向を分析します。

フィードバック:誤った回答が見つかった場合は、AIモデルにフィードバックを与え、精度を改善させます。

改善:分析結果を基に、プロンプトのテンプレートやAI利用ガイドラインを見直します。

このような検知と改善のサイクルを回し続けることで、AIシステムの性能と安全性を継続的に高めていくことができます。

ハルシネーション検知ツールやガバナンスツールの活用

近年、AIのハルシネーションを自動で検知したり、企業全体のAI利用を統制したりするための専門ツールが登場しています。ハルシネーション検知ツールは、AIの回答が事実に基づいているかを、信頼できる情報源と照合して評価する機能を持っています。

一方AIガバナンスツールは、誰がどのようにAIを利用しているかを可視化し、不適切な利用を防ぐためのポリシー適用やアクセス管理を一元的に行うことができます。これらのツールを導入することで、人間の目視チェックだけでは難しい大規模なAI利用のリスク管理を、より効率的かつ確実に行うことが可能になります。

まとめ

本記事では、生成AIがもっともらしい嘘をつく現象「ハルシネーション」について、その意味から原因、リスク、対策までを解説しました。ハルシネーションは、AIが確率に基づいて文章を生成する仕組みや、学習データの限界によって引き起こされます。この現象は、誤情報の拡散やビジネス上のミスにつながるリスクをはらんでいます。

対策として、個人レベルではプロンプトの工夫やクロスチェック、組織レベルではガイドライン策定やツールの活用が有効です。AIは便利な道具ですが、その回答は完璧ではありません。最終的には人間が内容を吟味し、判断する姿勢を忘れないことが、AIと上手に付き合っていく上で最も重要です。

Nottaは日本語に特化した国内最先端AI音声文字起こしツールです。